Cómo, cuándo y por qué hacer un Benchmark con los hallazgos de un estudio de UX

Escribe Ki Arnould

Artículo original Publicado en UserTesting blog en enero de 2015. Extracto.

Una colega que es profesional de UX recientemente me contó una historia divertida: su jefe se acercó a su escritorio y le dijo: “Quiero que agreguemos un Análisis Comparativo a nuestra estrategia de testeo”. Cuando ella le preguntó por qué, él le dijo que recientemente había oído que un competidor lo estaba haciendo y él quería mantenerse al día con los tiempos.

El Análisis Comparativo (o Benchmarking) es un tema candente en la industria de UX y, si se realiza correctamente, puede proporcionar una gran cantidad y calidad de información sobre cómo su sitio o aplicación se desempeña en el tiempo.

Desafortunadamente, a menudo se percibe sólo como “otra manera” de probar la usabilidad de un producto. La verdad es que el Análisis Comparativo es un compromiso, y requiere pensar y reflexionar sobre él, como lo requiere cualquier buen compromiso. Si se siguen las pautas a continuación se entregan se obtendrá una rica colección de datos que le mostrarán al equipo los logros y dificultades, que presenta un sitio o aplicación.

Entonces, ¿qué es el Análisis Comparativo (Benchmarking)?

Análisis Comparativo es el proceso de probar el progreso de un sitio o una aplicación a lo largo del tiempo.

Puede ser el progreso a través de diferentes iteraciones de un prototipo.

Puede ser el progreso en diferentes versiones de una aplicación.

E incluso puede ser progreso en diferentes sitios: el tuyo y el de tus competidores.

¿Cuál es el beneficio del Análisis Comparativo?

A muchas empresas les gusta realizar estudios de Análisis Comparativo porque muestran datos actualizados a medida que cambian con el tiempo. Agrega una dimensión cuantitativa a la investigación cualitativa que ya se está haciendo, que puede guiar los hallazgos y agregar peso a las sugerencias.

Además, siempre es bueno poder ¡compartir una bonita tabla con el gerente!

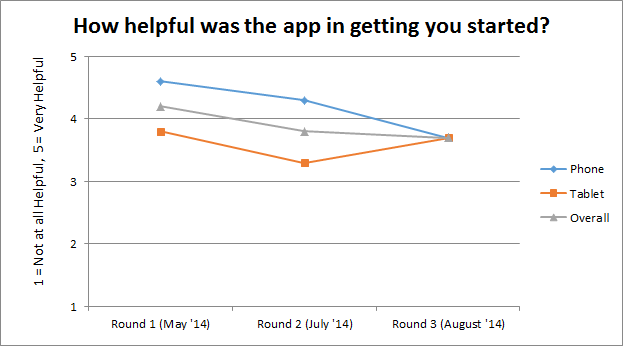

Cuadro 1: ¿Cómo ha ayudado App a los usuarios a comenzar a usarla ?

Es muy gratificante poder seguir los éxitos y fracasos de un producto a lo largo del tiempo. En el ejemplo anterior, podemos ver que la aplicación ha empeorado en ayudar a los usuarios a comenzar. Lo que sea que estaba haciendo el tutorial de la primera ronda, lo estaba haciendo bien; podría ser hora de eliminar el nuevo flujo del tutorial y volver a lo que funcionó.

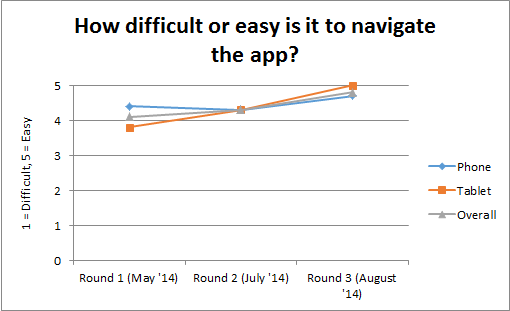

Cuadro 2: ¿Qué tan fácil o difícil es navegar en la App?

El Análisis Comparativo también puede indicar las formas en que las iteraciones posteriores de un producto están resolviendo ciertos problemas, como en el gráfico anterior. Como se puede ver, la navegación ha mejorado constantemente en cada iteración, ¡incluso alcanzó un puntaje perfecto para los usuarios de tablets en la última ronda! Sin ver un solo video, se puede descansar tranquilo sabiendo que los usuarios están recibiendo la aplicación sin dificultad.

¿Cómo se realiza un Análisis Comparativo?

Establecer el plan

Comienza con una conversación entre el equipo. Es necesario acordar exactamente lo que se espera averiguar, porque una vez que se haya decidido el guión para un estudio de Análisis Comparativo, no se deben realizar cambios en él. (¡Eso podría comprometer la integridad de la investigación!) Así que hay que preguntarse:

¿Qué estamos tratando de medir? ¿El tutorial para nuevos usuarios? ¿Qué mantiene a los usuarios actuales volviendo por más, o qué los hace irse? ¿Qué tan confiables somos? ¿Qué tan difícil o fácil es completar las tareas básicas en nuestro sitio?

¿Podemos comprometernos con esto de forma regular? ¿Tenemos el presupuesto? ¿Con qué frecuencia estamos produciendo nuevas versiones? ¿Con qué frecuencia queremos ver cómo nos comparamos con nuestros competidores?

Escriba el guion

Una vez que conozca las principales preguntas que el equipo quiere responder, se necesitará un script, un tipo de script muy específico.

1.- Las tareas deben estar orientadas a los objetivos y ser lo más básicas posible.

- Para ThinkGeek, “encuentra un producto que te gustaría comprar”.

- Para Evernote, “Crear una nueva nota”.

- Para Tax Slayer, “Registrarse para obtener una cuenta”.

2.- Las tareas deben evitar el uso de etiquetas o instrucciones descriptivas porque esos elementos podrían no estar allí en la próxima ronda de testeo

- “Haz clic en el ícono azul + para suscribirte a esta publicación.” = MAL

- “Suscribirse a esta publicación.” = BIEN

3.- Siga cada tarea con preguntas de evaluación y mantenga un patrón consistente de tareas y preguntas. ¡Usar preguntas mensurables como la escala de calificación o la opción múltiple le dará los datos que necesita para hacer esos gráficos hermosos!!

- Tarea: “Crea una nueva lista de reproducción con canciones de 3 artistas diferentes”.

- Escala de calificación: “¿Qué tan difícil (1) o fácil (5) fue crear una lista de reproducción?”

- Opción múltiple: “En comparación con otras aplicaciones de música, ¿fue más fácil, más difícil o más o menos lo mismo crear una lista de reproducción?”

- Más fácil

- Más difícil

- Parecido

- Otro / Ninguno de los de anteriores

Una vez que tienes un guión, es importante mantenerlo lo más consistente posible. Cualquier cambio en las tareas o preguntas puede comprometer los datos y dificultar la comparación de los resultados en diferentes rondas de pruebas, ¡así que no intentar jugar con ellas!

Defina su caracterización de usuarios

Finalmente, es importante utilizar el mismo número y tipo de usuarios.

Si el presupuesto lo permite, es mejor incluir más usuarios de los que se necesitaría en un estudio típico. Para las pruebas de usabilidad normales, 5-7 usuarios le darán una gran cantidad de información cualitativa. Pero debido a que estamos estudiando más las tendencias numéricas en un estudio de evaluación comparativa, se puede aumentar el número total de usuarios a 10, 20 o incluso 50.

No se necesita trabajar con las mismas personas cada vez; está bien tener una mirada fresca en cada versión del producto.

Sin embargo, el número total de usuarios y las características distintivas deben seguir siendo las mismos. Por ejemplo, si se realizó la prueba con 20 estudiantes universitarios la primera vez, también se debe realizar una prueba con 20 estudiantes universitarios para la próxima ronda.

¿Con qué frecuencia se deberían hacer estudios de evaluación comparativa?

La frecuencia y el distancia de los nuevos estudios depende de una variedad de factores, incluida la rapidez con que se producen los nuevos diseños y la cantidad de presupuesto de la que se dispone.

- Si el producto es uno que ya está definido, un estudio trimestral de evaluación comparativa puede ser todo lo que se necesita para controlar cualquier problema de rendimiento.

- Si se sacan nuevas iteraciones cada semana, se puede ser un poco más agresivo con la programación de testeos … y probablemente sea más pequeño con respecto al número total de usuarios.

- Y en algunos casos, si el producto tiene actualizaciones esporádicas, el Análisis Comparativo también puede ser esporádico.

Lo importante del Análisis Comparativo es ver el progreso en el tiempo, así independiente de lo que se haga, no es bueno ejecutar un estudio de Análisis Comparativo inicial y luego nunca más ejecutar otro. ¡O nunca se sabrán los beneficios que puede tener un estudio de Análisis Comparativo!

***********

Artículo original Publicado en UserTesting blog en enero de 2015. Extracto. Traducido con autorización de la autora. Todos los derechos pertenecen a su autora. Artículo y fotografía publicados en Capire.info bajo licencia Creative Commons. Toda reproducción total o parcial debe incluir la fuente www.capire.info y a sus autores. Fotografía JLM.